原文:How I Won Singapore’s GPT-4 Prompt Engineering Competition

译文来源:https://baoyu.io/translations/prompt-engineering/how-i-won-singapores-gpt-4-prompt-engineering-competition

作者:Sheila Teo

译者:宝玉 校验:Sydney

深度探索我在驾驭大语言模型(LLMs)中学到的策略

庆祝这一里程碑 — 真正的胜利在于宝贵的学习经历!

上个月,我非常荣幸地在新加坡政府科技局(GovTech)组织的首届 GPT-4 提示工程大赛中脱颖而出,这场比赛吸引了超过 400 名杰出的参与者。

提示工程是一门将艺术与科学巧妙融合的学科 — 它不仅关乎技术的理解,更涉及创造力和战略思考。这里分享的是我在实践中学到的一些提示工程策略,这些策略能够精准地驱动任何大语言模型为你服务,甚至做得更多!

作者的话: 在写作本文时,我特意避开了那些已经广泛讨论和记录的常规提示工程技巧。相反,我更希望分享一些我在实验中获得的新洞见,以及我个人在理解和应用这些技巧时的独到见解。希望你能从中获得乐趣!

本文涵盖以下主题,其中 🔵 代表初学者友好的技巧,而 🔴 代表高级策略:

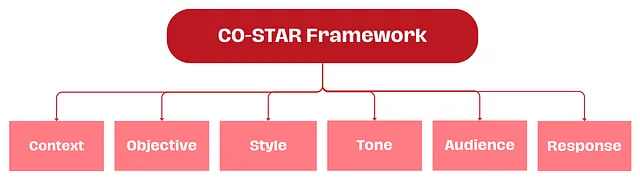

在使用大语言模型时,有效的提示构建至关重要。CO-STAR 框架,由新加坡政府科技局数据科学与 AI 团队创立,是一个实用的提示构建工具。它考虑了所有影响大语言模型响应效果和相关性的关键因素,帮助你获得更优的反馈。

CO-STAR 框架 — 作者提供的图像